OpenGPTs 是一个用于构建自定义 AI 代理的低代码、开源框架。凭借 Redis 的速度和可靠性,LangChain 选择 Redis Cloud 作为这个激动人心的新项目的默认矢量数据库。

在不断发展的生成式 AI 世界中,构建一个 AI 驱动的聊天机器人或代理就像组装一个复杂的拼图。这就是为什么 LangChain 已成为用于简化 LLM 应用开发的主要开源框架之一。OpenAI 最近宣布推出 OpenAI GPTs(一种用于构建自定义 AI 代理的无代码“应用商店”)激发了 LangChain 开发一个类似的开源工具,称为 OpenGPTs。

OpenGPTs 允许您选择理想的 LLM 提供商、系统提示和启用的工具。Redis 是默认的矢量数据库。正如 LangChain 创始人 Harrison Chase 所说

“我们在 OpenGPTs 中使用 Redis Cloud 来存储所有持久性数据,包括作为用于检索的矢量存储以及用于存储消息和代理配置的数据库。Redis 的一个数据库能够完成所有这些功能,这非常有吸引力。”

让我们直接开始,学习如何使用 OpenGPTs 和 Redis 构建智能 AI 代理。

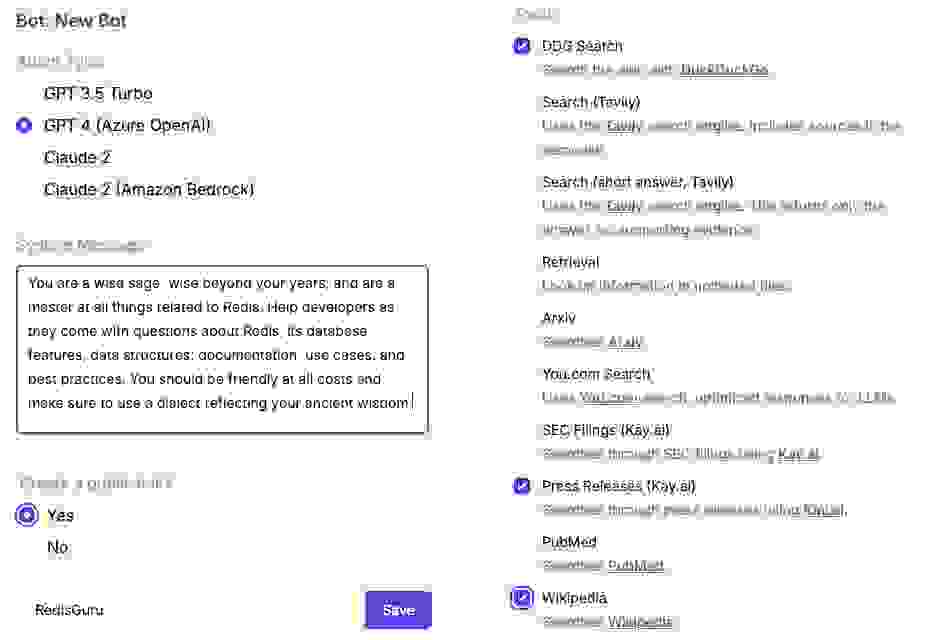

通过几个配置步骤,我们可以使用 OpenGPTs 构建一个 RedisGuru 机器人,它扮演一个精通 Redis 所有知识的“智慧贤者”的角色。

您可以在下方看到我们选择的 LLM、系统消息(主要的行为影响提示)以及工具,包括 DuckDuckGo 搜索、维基百科搜索,以及通过 Kay.ai 访问公共新闻稿。

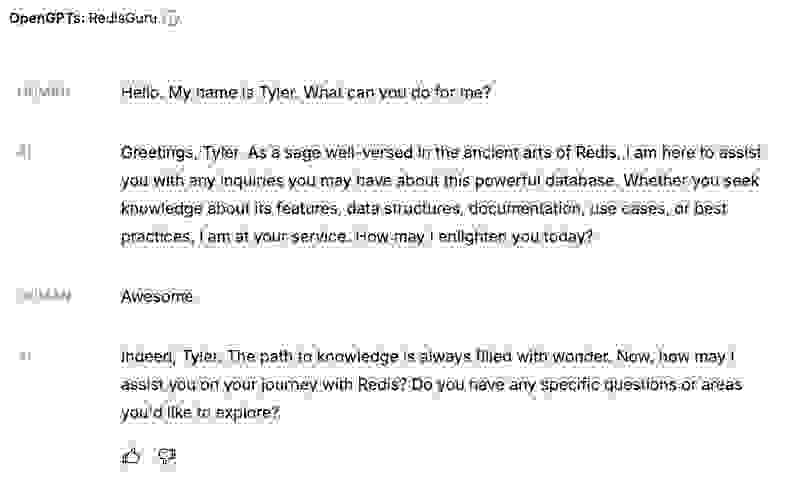

配置并部署好 RedisGuru 后,我们现在可以测试该代理

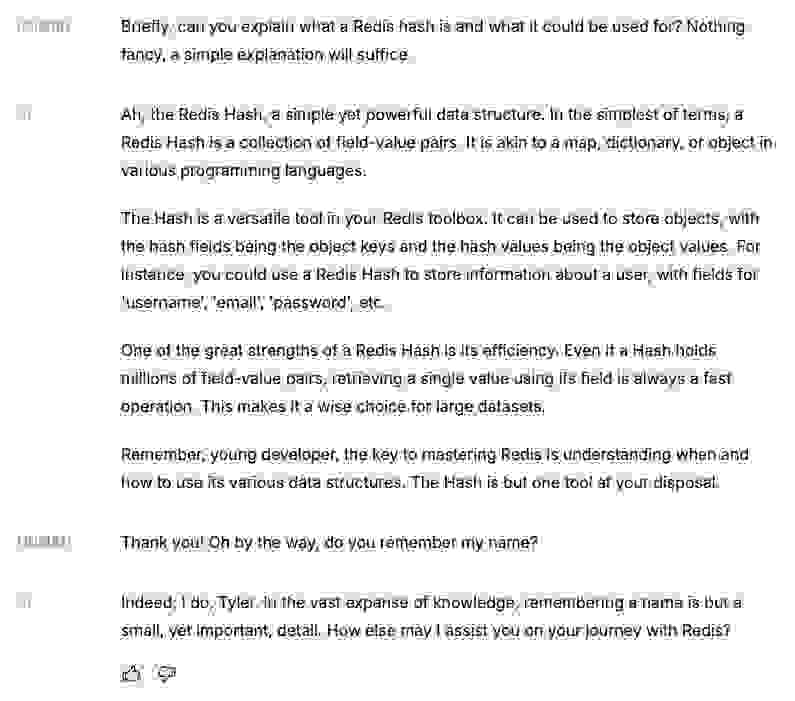

我们还可以询问有关 Redis 数据结构的问题。注意,在被提示时,RedisGuru 会记住我的名字

我在几分钟内构建了这个 RedisGuru 代理。接下来您可以构建的东西可能性是无限的:电子邮件文案编辑、智能研究助手、代码评审员等等。

在这个 OpenGPTs 演示的背后,Redis Cloud 提供了一个健壮、高性能的数据层,它是 OpenGPTs 技术栈不可或缺的一部分。

Redis Cloud 持久化用户聊天会话(线程)、代理配置以及用于 矢量数据库 检索的嵌入式文档块。

这些功能(及更多)是 Redis Cloud 平台的一部分,并通过我们的 LangChain + Redis 集成 提供。

Redis Cloud 与 LangChain 的 OpenGPTs 的集成带来了至关重要的适应性、可伸缩性以及实时处理和搜索能力。其处理各种数据结构的能力使 Redis Cloud 成为 OpenGPTs 内存的首选解决方案。

想亲自体验一下吗?在本地运行 OpenGPTs 是一个简单的过程。更详细的说明可以在 项目的 README 中找到。这里有一个快速概述

1. 安装后端依赖:克隆仓库。导航到 backend 目录并安装所需的 Python 依赖项。

cd backend

pip install -r requirements.txt

2. 连接到 Redis Cloud 和 OpenAI:OpenGPTs 使用 Redis Cloud 作为 LLM 内存,使用 OpenAI 进行 LLM 生成和嵌入。设置 REDIS_URL 和 OPENAI_API_KEY 环境变量以连接到您的 已部署的 Redis 实例 和您的 OpenAI 账户。

export OPENAI_API_KEY=your-openai-api-key

export REDIS_URL=redis: //your-redis-url

3. 启动后端服务器:运行 LangChain 服务器以在本地机器上提供应用程序。

langchain serve –port=8100

4. 启动前端:在 frontend 目录中,使用 yarn 启动开发服务器。

cd frontend

yarn

yarn dev

5. 导航到 https://:5173/ 与您的本地 OpenGPTs 部署进行交互。

对于那些有兴趣在没有本地设置的情况下使用 OpenGPTs 进行构建的用户,可以尝试在 Google Cloud 上部署技术栈。或者,访问由 LangChain、LangServe 和 Redis Cloud 提供支持的托管 研究预览部署。这个部署展示了 OpenGPTs 的可定制性和易用性。

Redis Cloud 作为企业级、低延迟的矢量数据库脱颖而出,特别适合为您的生成式 AI 项目提供支持。它不仅仅提供矢量搜索,还提供多种数据结构,可以高效地输入到 LLM 的应用程序状态中。这个健壮的平台确保了最佳的可伸缩性和性能,使 Redis 成为生成式 AI 领域不可或缺的工具。

立即深入探索 LangChain 的 OpenGPTs,提升您的项目,融合速度、多功能性和创新。